里昂智庫 | 丁文璿:負責任的人工智能

來源:法國里昂商學院時間:2022-04-29

2022年4月7日,,法國里昂商學院人工智能與商業(yè)分析教授丁文璿教授以“負責任的人工智能”為主題發(fā)表演講,,該演講發(fā)表于由華東師范大學上海國際首席技術(shù)官學院舉辦的名師講堂系列活動第十講中。來自各大高校的百余位師生通過線上直播形式聆聽了這場精彩講座,。

丁文璿

人工智能與商業(yè)分析教授

法國里昂商學院全球商業(yè)智能中心 (BIC) 副主任,、工商管理博士DBA導(dǎo)師

1.人工智能備受關(guān)注的話題與治理法規(guī)

【人工智能應(yīng)用中的倫理與治理問題】

當下人類社會在加速邁向數(shù)字化,、智能化的進程,人工智越來越多深層次廣泛地嵌入人們?nèi)粘I钪械姆椒矫婷?。在社會層面上,,我們看到很多人工智能技術(shù)的體現(xiàn),例如在工業(yè)生產(chǎn)中的智能制造與機器人工廠,,在物流倉儲行業(yè)中使用的移動式智能車,,在醫(yī)療健康行業(yè)中智能診斷與新藥的研發(fā),在金融股票市場上的高頻交易系統(tǒng),,還有在服務(wù)行業(yè)中廣泛出現(xiàn)的服務(wù)機器人,,如2022年北京冬奧會餐廳、奧運村與機器人廚師等場景中的應(yīng)用,。

此外,,隨著數(shù)字經(jīng)濟的發(fā)展,人工智能作為我們經(jīng)濟活動中的一種新生產(chǎn)力,,使得我們?nèi)肆Y源領(lǐng)域方面除了過去的藍領(lǐng)和白領(lǐng),,現(xiàn)在又出現(xiàn)了新的“數(shù)字領(lǐng)”。因此,,很多人擔心人工智能技術(shù)的發(fā)展可能會使相當一部分人失業(yè),。與此同時,人工智能技術(shù)的使用也帶來了其它一些問題與風險,,如電商與直播平臺廣泛使用的用戶偏好推薦和大數(shù)據(jù)殺熟的現(xiàn)象,,人臉識別帶來的隱私安全問題,自動駕駛事故頻發(fā)問責難的問題,,人工智能技術(shù)被不法分子濫用從事網(wǎng)絡(luò)犯罪,、生產(chǎn)和傳播假新聞,、合成虛假影像等等。引發(fā)了社會大眾,、媒體,、各行各業(yè)研究學者們對人工智能倫理與治理方面的廣泛討論。

通過梳理我們發(fā)現(xiàn),,大家都在探討一些非常相似的概念,,雖然用了不同的詞匯,但究其背后的定義,,大致可以總結(jié)為:隱私問題,、人工智能算法的公平公正性(或者偏見與歧視)問題、人工智能決策的透明與可解釋性問題,、人工智能使用的安全與可控問題,、以及人工智能的責任與對人工智能的信任問題。

【風險應(yīng)對與解決方案】

為了應(yīng)對與解決這些風險問題,,許多政府機構(gòu),、非盈利組織、大型高科技產(chǎn)業(yè)等相繼出臺了一系列條例,、法規(guī)和措施,。例如,2016年4月歐盟出臺了《通用數(shù)據(jù)保護條例》,,2017年12月,,國際電氣和電子工程師協(xié)會(IEEE)出臺了《人工智能設(shè)計的倫理準則》, 2020年歐盟進一步出臺了人工智能的規(guī)范和如何建立可信任的人工智能,。同時,,許多大型互聯(lián)網(wǎng)企業(yè)包括谷歌、臉書,、騰訊,、百度、京東等都出臺了相應(yīng)的人工智能系統(tǒng)開發(fā)的倫理框架,。

最近,,在2022年3月20日,中共中央辦公廳,、國務(wù)院辦公廳印發(fā)了一個最新的《關(guān)于加強科技倫理治理的意見》,。它是中國首個國家層面科技倫理治理指導(dǎo)性文件。該文件強調(diào)智能科技服務(wù)人類的時候,,必須要增加人類的福祉,,不僅必須要尊重生命的權(quán)利(尤其用于在生命科學和生物科技類方面的技術(shù)),還要尊重個人的隱私,。而且,,科技服務(wù)一定要堅持公平公正的原則,對做出的決策過程以及機制保持公開透明,,并對可能產(chǎn)生的風險能夠及時控制,。該文件為新興技術(shù)倫理治理設(shè)置了“紅綠燈”。

2.人工智能治理的挑戰(zhàn)

雖然已經(jīng)出臺了各種各樣的關(guān)于對人工智能技術(shù)從數(shù)據(jù)采集與管理,、算法設(shè)計到系統(tǒng)使用的條例與法規(guī),,但是,我們對人工智能的風險治理仍然面臨巨大的挑戰(zhàn),。難點或者關(guān)鍵點就在于:如果讓機器具有人類倫理道德意識,,我們就必須設(shè)計相應(yīng)的算法,而我們?nèi)祟悓Φ赖碌男再|(zhì)和關(guān)鍵的道德價值還沒有達到統(tǒng)一的共識,。尤其在哲學層面上,,全世界對倫理道德的評判標準和價值取向就有不同的流派和標準。例如,,在不同的場景下,,我們該如何決定與某個道德規(guī)則所對應(yīng)的道德代碼的價值取向?是應(yīng)該采用“功利主義(utilitarian cost-benefit)”方法還是“康德式的成本效益方法(某些價值是不能被交易的,,不管它會有多少好處)”,?即使經(jīng)濟學中廣泛的答案是采用功利主義的,對它的算法代碼量化也是非常困難的:比如我們應(yīng)該如何對一輛無人駕駛汽車進行編程,,讓它在行駛中面對行人躲避時,,是重視車外三個老人的生命,還是保護車內(nèi)一個中年人的生命,?如果車內(nèi)是孕婦而車外是兒童,,又該如何決策呢?如果人類社會多個道德規(guī)則都符合該場景的應(yīng)用,,那么這些道德規(guī)則該如何競爭(即,,如何設(shè)計道德規(guī)范的競爭規(guī)則)才使得機器最終表現(xiàn)出值得我們每個使用者都信賴,都認為是公平的智能行為呢,?又例如,,各企業(yè)在運用人工智能技術(shù)時應(yīng)該如何平衡隱私、公平,、準確和安全之間的權(quán)衡,?在按照經(jīng)濟學追求最大經(jīng)濟利益的原則下,所有這些類型的風險都可以避免嗎,?

3.更新人工智能的頂層設(shè)計是解決風險治理的核心

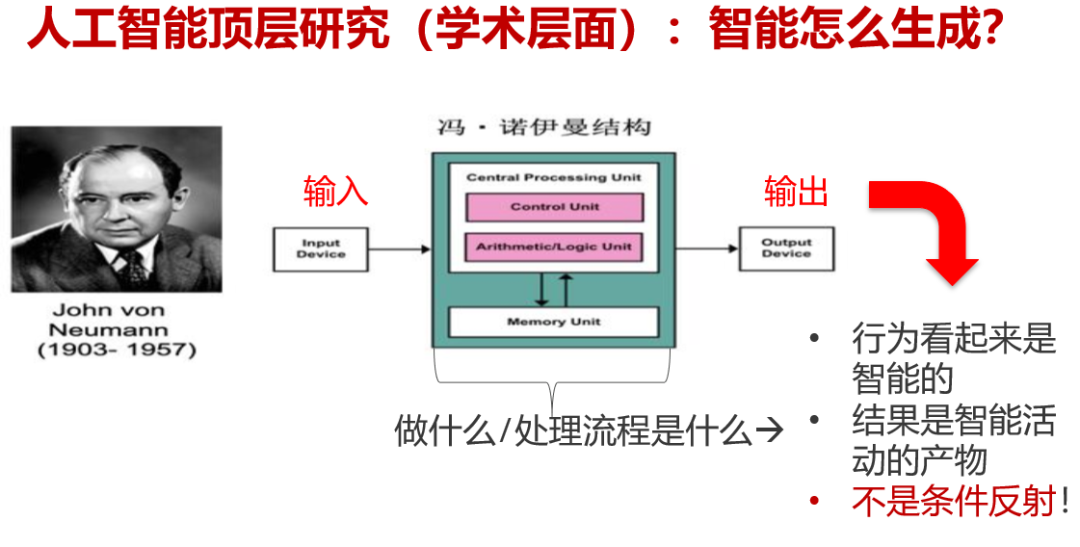

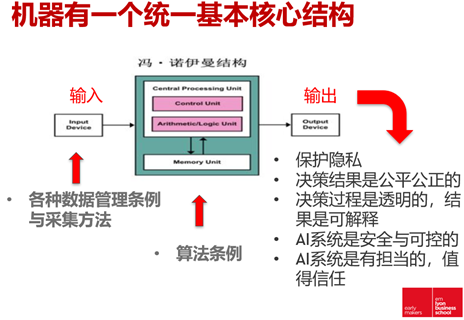

我們知道無論智能機器外形怎樣變化,,它們都有一個統(tǒng)一的基本架構(gòu)核心:輸入→CPU處理→輸出(如圖所示)。

我們知道機器的智能行為并不是一個條件反射,。我們?nèi)斯ぶ悄苎芯筷P(guān)注的是:中間這部分處理流程做了什么,,才使得最后的輸出端看起來是智能的,!因此從過去直到現(xiàn)在,研究學者們的共同的想法就是如何給非生命的機器賦予人類意識思維的過程,。

目前出現(xiàn)的問題是:我們讓機器生成智能的方式 – 人工智能 – 帶來了人們對它的倫理和風險治理的訴求,。比如,當前讓機器生成智能的方法之一是利用(大)數(shù)據(jù)來找模式,,并把這個模式定義為機器通過“學習”產(chǎn)生了智能,。它的目的就是要從輸入的數(shù)據(jù)中找個類似于Y =?(wi,xi), for i = 1, 2, …n 的模式;這里xi是輸入,,每個輸入都有一定的權(quán)重wi(參數(shù)),,Y是輸出。

在這個過程中,,研究者們所關(guān)心的是,,不知道該怎么讓機器產(chǎn)生學習能力。因此,,需要用相同場景下的大量數(shù)據(jù)對機器訓練,。在訓練的時候,還要假設(shè)我們對這些訓練數(shù)據(jù)的內(nèi)在生成機制是事先知道的(即數(shù)據(jù)的分布是已知的),。通過不停的訓練,,使得輸出端達到預(yù)想的期望結(jié)果。這時,,如果有個新的數(shù)據(jù)進來,,帶入這樣一個訓練好的模式里,就得到一個對應(yīng)的Y,,它就表征了機器的預(yù)測結(jié)果,。為了達到非常好的輸出結(jié)果,系統(tǒng)開發(fā)者們冥思苦想了不同方法,,如在輸入和輸出端之間增加多層“學習”機制(即,,各種神經(jīng)網(wǎng)絡(luò)的深度學習是一個例子)。通過不斷的調(diào)參(調(diào)節(jié)權(quán)重),,希望輸出端得到很好的結(jié)果,。

如果需要解決的問題場景的數(shù)據(jù)同機器已經(jīng)訓練的數(shù)據(jù)不是來自同一場景的,那么運用已經(jīng)訓練好的模式進行決策,,就會產(chǎn)生“偏見與歧視”問題,。這是因為過去的訓練數(shù)據(jù)不足以保證其訓練得到的智能適用于新的場景特征。所以,,這種“依賴數(shù)據(jù)生成模式并被定義為機器智能的方式”的致命點就是:

- 過去學習到的知識不能被再利用(即這個學習到的智能是不能夠傳遞的,,對每一個新問題的求解都需要有一個對應(yīng)的數(shù)據(jù)集進行訓練),因為它是依賴訓練數(shù)據(jù)而生成智能的,,它是沒有記憶的,;

- 這種智能生成的方式天生就會產(chǎn)生“偏見與歧視”,,因為訓練數(shù)據(jù)集不可能代表所有未知場景的特征屬性(即新的場景也不一定符合訓練數(shù)據(jù)的特征);

- 輸入端到輸出端模式撲捉到的是輸入數(shù)據(jù)對結(jié)果的相關(guān)性關(guān)系,,而非因果關(guān)系,,因此輸出的結(jié)果不一定能夠完全反映場景數(shù)據(jù)內(nèi)在的本質(zhì)屬性;

- 輸入到輸出的中間調(diào)參以及多層深度學習的網(wǎng)絡(luò)關(guān)系是不透明的,,其處理過程和輸出端的最終結(jié)果都不具有可解釋性。

因此,,我們認為解決人工智能倫理問題的關(guān)鍵還是在于:機器生成智能的方式,,即在從輸入到輸出的中間處理層,我們該設(shè)計什么樣的算法才使得在輸出端我們能看到:機器表現(xiàn)出的行為不僅是智能的,,更重要的是:它的智能行為的產(chǎn)生或者在生成智能決策時用到的數(shù)據(jù)是保護隱私的,;這些智能的行為和決策結(jié)果是以人類的利益為中心并且給人類帶來福祉的;輸出端的行為或者決策結(jié)果不僅是公平公正的,,而且機器內(nèi)部生成決策的過程是透明的,,決策結(jié)論也是能夠給站在輸入端的用戶或者消費者解釋清楚的。

在更新人工智能頂層設(shè)計時,,有幾個關(guān)鍵點需要考慮:

- 產(chǎn)生智能的要素:我們是否必須要用“涉及人類隱私/敏感信息的”數(shù)據(jù)作為機器智能生成的要素,,并以此作為提供“個性化”服務(wù)的基礎(chǔ)?

- 產(chǎn)生智能的方式:我們是否要靠“大數(shù)據(jù)堆積去產(chǎn)生機器智能”,?

- 算法決策判定與價值取向:是否必須遵循經(jīng)濟學理論依賴最大(優(yōu))“效益”原則,,而不考慮“利他”要素?

- 機器的智能行為作用于誰,最終目的是什么,?

4.“盡責五元素”框架落地人工智能

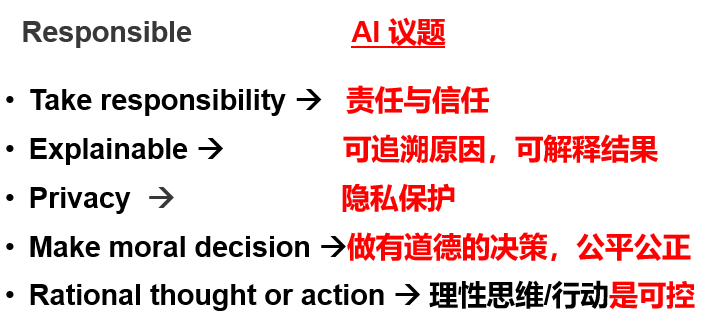

我們提出負責任人工智能的框架來解決當前人工智能所帶來的問題,。根據(jù)Merriam-Webster字典,“負責任(Responsible)”這個詞包含5個層面涵義:

- liable to be called on to answer; liable to legal review or in case of fault to penalties → take responsible, accountability

- liable to be called to account as the primary cause, motive or agent → explainable

- able to answer for one’s conduct and obligations → covering privacy

- able to choose between right and wrong, having a capacity for moral decisions

- capable of making rational thought or action

這5個層面涵義剛好對應(yīng)人工智能治理中的5個問題(如圖示)

“盡責五元素”如果落地到“人”,,則需要考慮“開發(fā)者”(Developer,,人工智能系統(tǒng)的開發(fā)和算法編碼者),“采納者” (Deployer,,決定在本公司或組織是否采用人工智能系統(tǒng)的決策者),,“使用者”(User,操作或使用人工智能系統(tǒng)的人),,和“消費者或被作用者”(Consumer,,接受人工智能系統(tǒng)服務(wù)的人群)。

我們需要檢測采用人工智能系統(tǒng)的目的是什么,?誰是受益人,?作用于“誰”的問題 。比如:如果將人工智能應(yīng)用到對公司或組織內(nèi)員工的管理,,那么,,企業(yè)對員工的這種管理能夠運用到什么程度,?使用中產(chǎn)生的“負”面后果該由誰負責:是開發(fā)者,采納者,,還是使用者負責,?這一點在醫(yī)療健康行業(yè)使用AI技術(shù)時尤為重要,因為它關(guān)系到患者的生命保障與權(quán)益,。

由于目前我們所有的人工智能算法大都是由人設(shè)計的,,因此它的邏輯設(shè)計就反映了開發(fā)者的價值取向,包括用什么樣的數(shù)據(jù)作為訓練集,,場景該怎么描述,,應(yīng)該選擇哪些特征變量等。我們需要的是以“人(被作用者)”為本的,,具有“利他”性的負責任人工智能技術(shù),。我們要知道科學是在給定(實驗,分析,,假設(shè))條件下探求世界的規(guī)律,,是“求真”的結(jié)果。但是,,這個結(jié)果至少不能事前確定其有用性,!而技術(shù)本質(zhì)是“務(wù)實”, 是在已知終點的情況下尋求實現(xiàn)結(jié)果的適當條件,。我們希望人工智能技術(shù)越來越科學,!